Nvidia представила потрясающие результаты работы своих новых чипов Blackwell в тестах MLPerf Training v5.0. Архитектура Blackwell, созданная для удовлетворения возрастающих потребностей производительности современных приложений искусственного интеллекта, показала наивысшую производительность во всех бенчмарках, став единственной платформой, предоставившей результаты по всем тестам. Особенно впечатляющим является результат на самом сложном тесте, посвященном большим языковым моделям (LLM) — обучении модели Llama 3.1 405B.

Результаты, полученные на суперкомпьютерах Tyche и Nyx, а также при поддержке CoreWeave и IBM (2496 GPU Blackwell и 1248 CPU Nvidia Grace), были проверены и подтверждены ассоциацией MLCommons, объединяющей более 125 членов и партнёров.

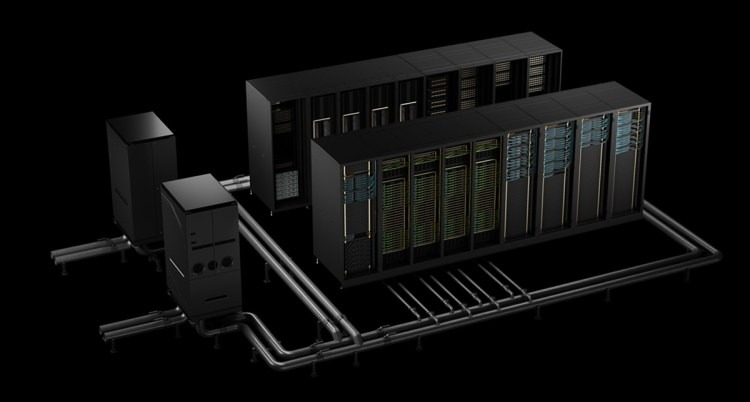

По сравнению с предыдущим поколением архитектуры Blackwell показал прирост производительности 2,2 раза по результатам теста Llama 3.1 405B. На тесте Llama 2 70B LoRA fine-tuning системы Nvidia DGX B200, оснащённые восемью GPU Blackwell, продемонстрировали увеличение производительности в 2,5 раза по сравнению с предыдущим результатом при использовании такого же количества графических процессоров. Такое существенное повышение производительности достигнуто благодаря жидкостному охлаждению стоек, 13,4 ТБ когерентной памяти на стойку, применению технологии межсоединения Nvidia NVLink пятого поколения и Nvidia NVLink Switch для масштабирования, а также сетевой технологии Nvidia Quantum-2 InfiniBand для горизонтального масштабирования. Кроме того, усовершенствования в программном стеке Nvidia NeMo Framework повышают эффективность обучения многомодальных LLM следующего поколения, что важно для выхода на рынок агентивных AI-приложений.

Эти приложения-агенты, способные рассуждать и решать задачи, будут работать в «AI-фабриках» — центрах обработки данных, оптимизированных для работы с подобными системами. Они будут генерировать ценную информацию, применимую во многих отраслях и академических областях. Платформа Nvidia для центров обработки данных включает GPU, CPU, высокоскоростные сети и обширный набор программного обеспечения, включая библиотеки Nvidia CUDA-X, фреймворк NeMo, Nvidia TensorRT-LLM и Nvidia Dynamo. Такое комплексное решение позволяет организациям ускорить обучение и внедрение моделей, сократив время выхода на рынок.

Дэйв Сальватор, директор по продуктам ускоренных вычислений в Nvidia, сообщил, что компания делает акцент на результатах предварительного и последующего обучения, назвав это началом инвестиций в ИИ. Вывод моделей в эксплуатацию даст прибыль. Также он подчеркнул, что MLPerf является надёжным бенчмарком, позволяющим объективно сравнивать производительность разных систем.

Nvidia собирается улучшать производительность Blackwell посредством программных оптимизаций и адаптации под новые, более сложные задачи. Компания переходит от производителя чипов к созданию целых систем, стоек и центров обработки данных, называемых «AI-фабриками», для предоставления комплексных решений, ускоряющих развитие искусственного интеллекта.